- Herramienta

- Fuente: Campus Sanofi

- 12 jun 2025

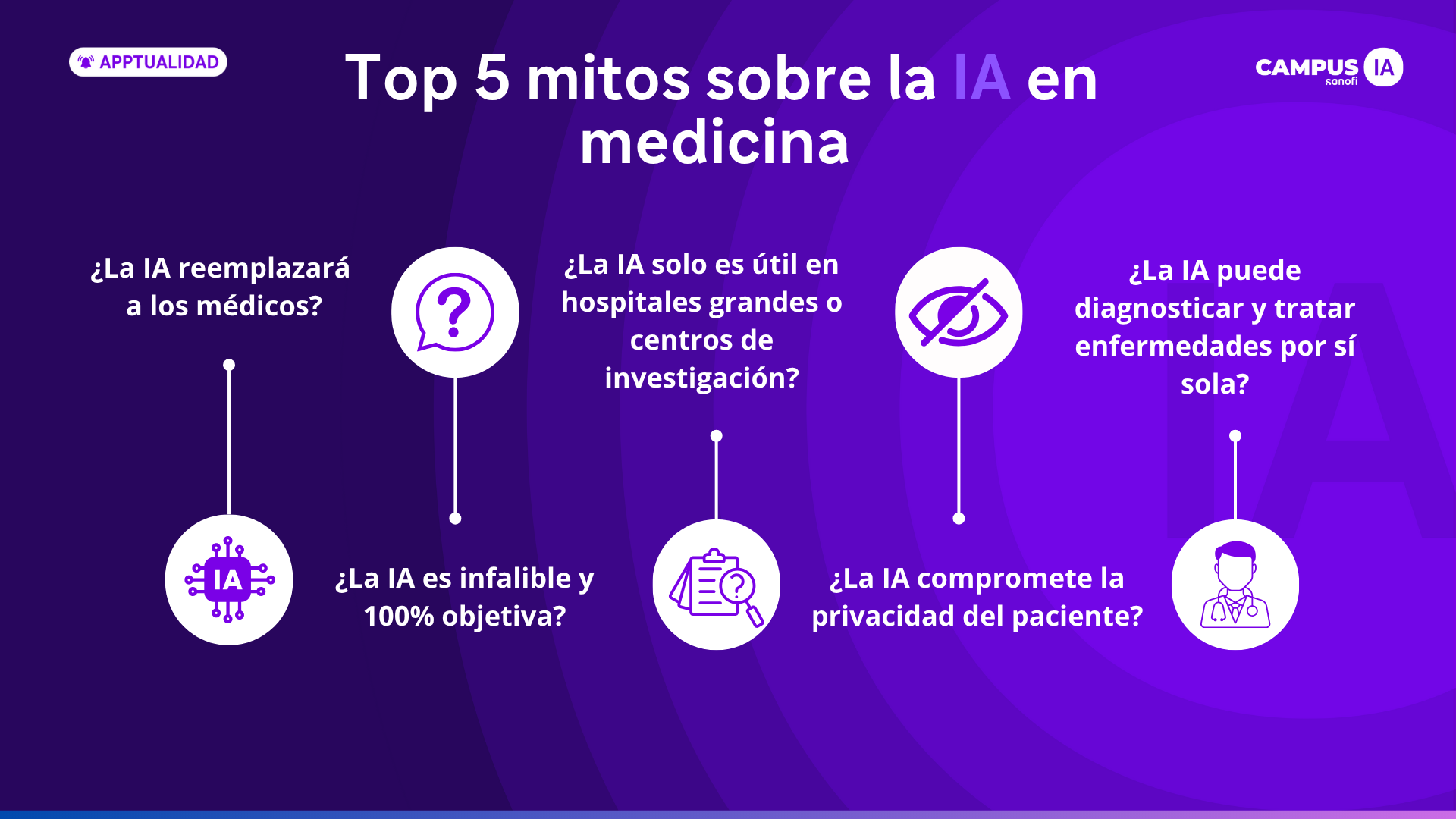

Top 5 mitos sobre la inteligencia artificial en medicina

En este artículo, abordamos y aclaramos los cinco mitos más comunes sobre el uso de la IA en medicina, contrastando cada uno con la evidencia científica más actual y las recomendaciones de organismos internacionales como la Organización Mundial de la Salud (OMS), la Comisión Europea y publicaciones académicas de renombre.

1. “La IA reemplazará a los médicos”

Este es quizás el mito más difundido. La realidad es que la IA no sustituye el criterio clínico ni la empatía del profesional sanitario, sino que actúa como herramienta de apoyo para mejorar la eficiencia, la precisión diagnóstica y la gestión clínica.

Según el informe de la OMS sobre ética e inteligencia artificial, la supervisión humana es indispensable en todas las fases del uso de IA en salud1. La IA puede automatizar tareas específicas, como la priorización de estudios radiológicos, pero las decisiones clínicas deben mantenerse bajo control médico.

Estudios como los publicados en The Lancet Digital Health también confirman que la combinación de profesionales sanitarios con IA mejora los resultados diagnósticos, especialmente en áreas como radiología o dermatología2.

2. “La IA es infalible y 100% objetiva”

La objetividad de la IA no es exacta. Si los datos de entrenamiento están sesgados o incompletos, los algoritmos pueden perpetuar esos errores, afectando la equidad en el acceso y calidad asistencial.

Un estudio revelador publicado en Science demostró que un algoritmo ampliamente utilizado en EE. UU. subestimaba el riesgo clínico de pacientes afroamericanos, ya que se basaba en costos históricos y no en criterios clínicos3.

Además, en Nature Medicine se identificaron fallos clínicos significativos provocados por estratificaciones erróneas en modelos de aprendizaje automático, destacando la importancia de validar clínicamente cualquier herramienta antes de su adopción4.

3. “La IA solo es útil en hospitales grandes o centros de investigación”

Este mito ha quedado superado por la realidad de múltiples aplicaciones accesibles y adaptables. Existen herramientas que permiten a centros pequeños y consultas privadas beneficiarse de la IA para, entre otras funciones:

- Gestionar citas de forma más eficiente.

- Reducir carga administrativa mediante resúmenes automatizados.

- Apoyar el triaje clínico o priorizar pacientes segú n síntomas.

Según la Comisión Europea, la IA puede mejorar significativamente la atención primaria, especialmente si se diseña con un enfoque centrado en el usuario5. La clave está en adoptar soluciones interoperables, éticas y sostenibles.

4. “La IA compromete la privacidad del paciente”

La preocupación por la privacidad es legítima, pero no implica que la IA sea incompatible con el respeto a la confidencialidad médica. Todo sistema de IA implementado en el ámbito clínico debe cumplir con regulaciones como el RGPD (en Europa) o la HIPAA (en EE. UU.).

El informe de la OMS establece seis principios éticos clave, incluyendo la transparencia, la protección de la autonomía humana y la rendición de cuentas1. Además, existen soluciones tecnológicas que permiten el anonimato y la trazabilidad de los datos clínicos sin comprometer la utilidad de la IA.

La OMS recomienda seis principios éticos fundamentales para el uso de la IA en medicina, entre ellos:

- Protección de la autonomía humana.

- Transparencia.

- Inclusión y equidad.

- Seguridad y responsabilidad.

La clave es implementar IA de forma ética, supervisada y cumpliendo estrictamente con los estándares legales y técnicos de cada país.

5. “La IA puede diagnosticar y tratar enfermedades por sí sola”

Ningún sistema de IA tiene autorización para diagnosticar o tratar pacientes de forma autónoma. Su función es apoyar, no sustituir.

La FDA y la EMA coinciden en que la IA en medicina debe categorizarse como herramienta médica bajo supervisión. El diagnóstico debe seguir siendo una decisión humana basada en contexto clínico, historia, exploración y juicio profesional6.

Incluso las herramientas más avanzadas, como las que detectan retinopatía diabética o cáncer de piel, requieren revisión y validación médica continua para asegurar su fiabilidad y relevancia clínica.

Conclusión: De mitos a evidencia

La IA representa una oportunidad para fortalecer la práctica clínica, mejorar el acceso a la atención y personalizar los tratamientos. Pero para que esto ocurra, es necesario desmitificar su funcionamiento y comprender sus verdaderos alcances y limitaciones.

Desde Campus IA, promovemos una adopción responsable, informada y ética de la inteligencia artificial en la medicina. El futuro no pasa por reemplazar al profesional sanitario, sino por acompañarlo, potenciarlo y proteger siempre la relación médico-paciente.

|

Los recursos y funcionalidades mencionados en este sitio web no han sido desarrollados, financiados, promovidos ni validados por Sanofi. Sanofi los recopila y describe en Campus IA con fines puramente ilustrativos, y no se responsabiliza de la exactitud o integridad de la información resultante de su uso ni de las opiniones expresadas sobre los mismos. Es responsabilidad del profesional sanitario asegurar el uso adecuado y la supervisión de los resultados obtenidos a través de la inteligencia artificial, así como verificar la veracidad de la información y la interpretación de las opiniones de los expertos. La inteligencia artificial no debe sustituir el juicio humano del profesional sanitario, sino complementar el ejercicio de su profesión. |

Referencias

- World Health Organization. (2021). Ethics and governance of artificial intelligence for health. https://www.who.int/publications/i/item/9789240029200

- Rodríguez-Ruiz, A. et al. (2019). Stand-alone artificial intelligence for breast cancer detection in mammography: comparison with 101 radiologists. The Lancet Digital Health, 1(1), e35–e43.

- Obermeyer, Z. et al. (2019). Dissecting racial bias in an algorithm used to manage the health of populations. Science, 366(6464), 447–453.

- Oakden-Rayner, L. (2020). Hidden stratification causes clinically meaningful failures in machine learning for medical imaging. Nature Medicine, 26, 1322–1325.

- European Commission. (2023). Artificial Intelligence in Healthcare: Trustworthy, Human-Centric & Sustainable. https://digital-strategy.ec.europa.eu

- U.S. Food and Drug Administration. (2023). Good Machine Learning Practice for Medical Device Development: Guiding Principles. https://www.fda.gov

MAT-ES-2600776 V1 Marzo 2026