- Herramienta

- Fuente: Campus Sanofi

- 18 jun 2025

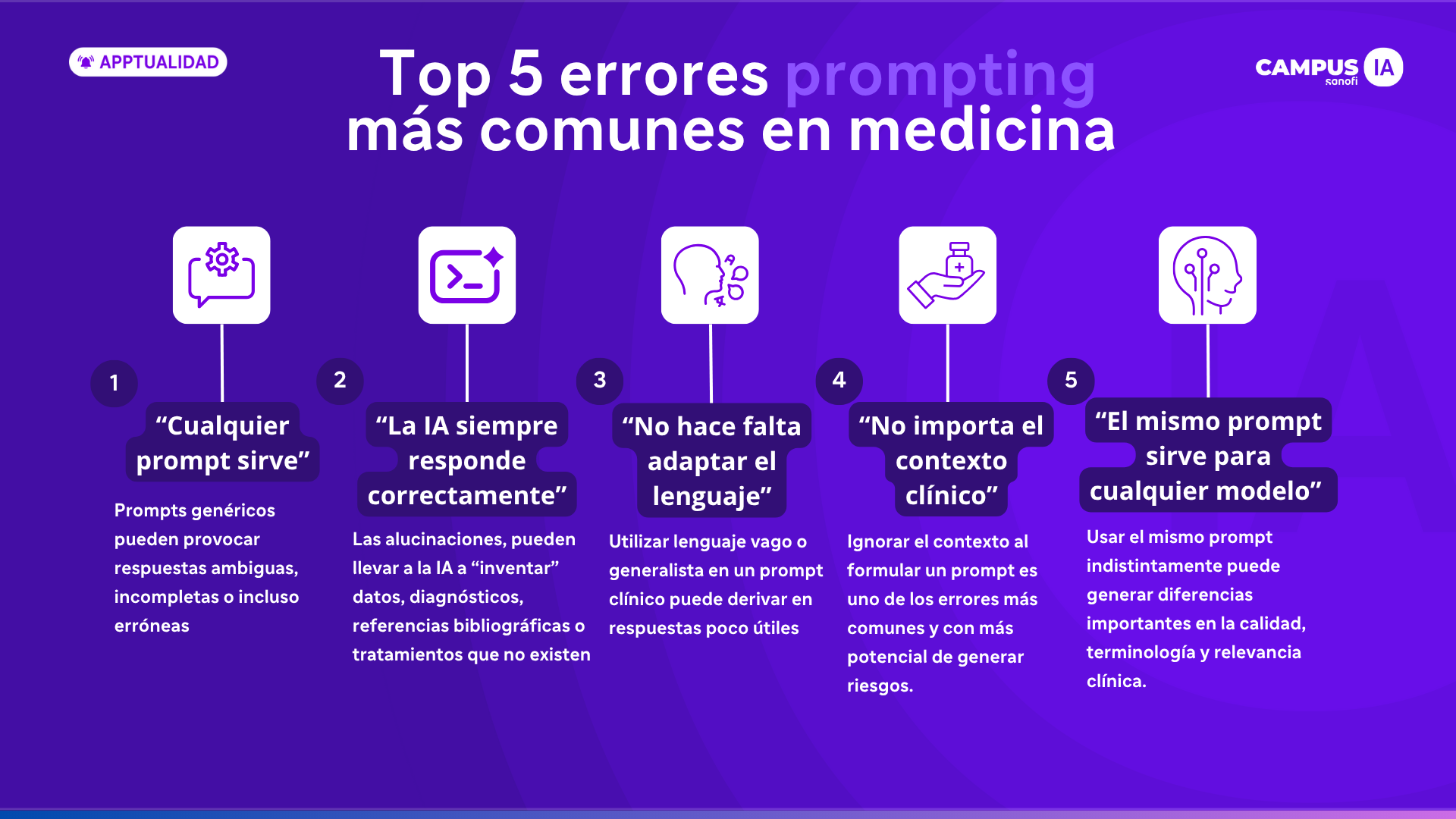

Top 5 errores de prompting más comunes en medicina

Uno de los factores más decisivos para obtener buenos resultados es el diseño del prompt: el mensaje o instrucción que se le da a la IA. A pesar de su aparente simplicidad, redactar un prompt eficaz en el ámbito sanitario exige precisión, contexto y claridad.

En este artículo analizamos los 5 errores más comunes al crear prompts médicos y cómo evitarlos para lograr una interacción más útil, segura y basada en evidencia.

- ¿Quieres aprender a crear prompts perfectos en medicina? Haz clic aquí para conocer todo lo necesario para llevar tus prompts al siguiente nivel.

- También te recomendamos que conozcas los 10 tips esenciales para optimizar consultas médicas con IA.

1. “Cualquier prompt sirve”

Una de las creencias más extendidas es que cualquier mensaje, por básico que sea, generará una respuesta útil de un modelo de lenguaje. Esta idea es especialmente peligrosa en medicina, donde un matiz puede cambiar por completo el significado clínico de una frase.

Prompts genéricos como “Resume este caso” o “Haz un diagnóstico” pueden provocar respuestas ambiguas, incompletas o incluso erróneas. Esto se debe a que el modelo necesita instrucciones claras para saber qué enfoque seguir: ¿resumir para un informe clínico o para una reunión interdisciplinaria?, ¿diagnóstico presuntivo o diferencial?

Ejemplo de error:

"Resume este informe médico."

💡Sin contexto ni objetivo claro, la IA puede omitir información clave o generar un texto superficial. (1)

Prompt corregido:

"Resume en 5 líneas esta historia clínica para presentar en sesión de casos. Incluye antecedentes relevantes, hallazgos principales y plan terapéutico."

💡Solución: Especifica el contexto clínico, el objetivo del texto y el formato esperado. Un prompt bien formulado no solo mejora la calidad del resultado, sino que ahorra tiempo de edición y reduce riesgos clínicos.

2. “La IA siempre responde correctamente”

El segundo gran error es asumir que, si una respuesta suena coherente, entonces es verdadera. Los modelos de lenguaje no entienden ni verifican hechos: simplemente generan texto basándose en patrones lingüísticos estadísticos.

Este fenómeno, conocido como alucinación, puede llevar a la IA a “inventar” datos, diagnósticos, referencias bibliográficas o tratamientos que no existen o no son adecuados. En medicina, esto puede tener consecuencias graves si no se detecta a tiempo.

Incluso para tareas simples como redactar un resumen, es importante revisar el contenido generado y verificar que no contenga errores sutiles, como asociaciones erróneas entre síntomas, omisión de datos relevantes o lenguaje no apropiado.

Ejemplo de error:

"¿Cuál es el tratamiento de elección para fiebre tifoidea?"

💡Puede responder con una solución desactualizada o no alineada con las guías oficiales.

Prompt corregido:

"Según las guías clínicas actuales de la OMS, ¿cuál es el tratamiento de primera línea para fiebre tifoidea en adultos, en un contexto de alta resistencia a fluoroquinolonas?"

💡 Solución: Solicita siempre referencias actualizadas, menciona organismos como la OMS, CDC o guías nacionales, y revisa que la respuesta esté alineada con la práctica clínica local. (2,3)

3. “No hace falta adaptar el lenguaje médico”

La precisión terminológica es fundamental en medicina. Utilizar lenguaje vago o generalista en un prompt clínico puede derivar en respuestas poco útiles o irrelevantes. La IA necesita que el usuario utilice los mismos códigos lingüísticos con los que ha sido entrenada, y eso incluye nombres de enfermedades, valores de laboratorio, escalas clínicas y siglas comunes.

Por ejemplo, un prompt que diga “explica qué tiene el paciente” es tan amplio que puede desencadenar una respuesta superficial. En cambio, si se incluyen términos como “síndrome coronario agudo”, “Troponina I elevada” o “escala de Killip II”, el modelo es capaz de producir una respuesta mucho más precisa y contextualizada.

Ejemplo de error:

"Explica qué podría tener este paciente con dolor de pecho."

💡Prompt muy amplio y poco específico que puede generar respuestas erroneas o poco detalladas.

Prompt corregido:

"Describe el diagnóstico diferencial de un varón de 60 años con dolor torácico tipo opresivo, irradiado al brazo izquierdo, con antecedentes de hipertensión y troponina elevada."

💡Solución: Emplea términos médicos estandarizados, y si es necesario, códigos CIE, valores numéricos o descripciones estructuradas. Esto también facilita la reproducibilidad del contenido generado. (4)

4. “No importa el contexto clínico”

En medicina, los datos no existen en el vacío. Una misma patología puede requerir tratamientos distintos según el perfil del paciente, sus comorbilidades, su edad o el nivel de atención sanitaria. Ignorar este contexto al formular un prompt es uno de los errores más comunes y con más potencial de generar riesgos.

Por ejemplo, un prompt que diga “indica tratamiento para neumonía” no diferencia si el paciente es pediátrico, adulto inmunocomprometido, o si se encuentra en un entorno ambulatorio o en UCI. Cada uno de estos escenarios exige decisiones clínicas distintas.

Un prompt bien contextualizado no solo mejora la calidad de la respuesta, sino que permite que la IA actúe de forma más alineada con las buenas prácticas clínicas.

Ejemplo de error:

"¿Qué antibiótico usar en neumonía?"

💡No se sabe si el paciente es ambulatorio, hospitalizado o inmunosuprimido. Falta información esencial y contexto clínico.

Prompt corregido:

"Sugiere un antibiótico empírico para una paciente de 75 años con neumonía adquirida en la comunidad, antecedentes de EPOC y alergia a penicilina, ingresada en planta de hospitalización."

💡 Incluye siempre datos contextuales como edad, sexo, antecedentes, entorno clínico (hospital, consulta, urgencias), alergias relevantes y datos clave de laboratorio o imagen. (5)

5. “El mismo prompt sirve para cualquier modelo”

No todos los modelos de IA están entrenados de la misma forma. Existen modelos generalistas como ChatGPT o Claude, y modelos especializados en medicina como Med-PaLM, BioGPT o PubMedGPT. Usar el mismo prompt indistintamente puede generar diferencias importantes en la calidad, terminología y relevancia clínica de las respuestas.

Los modelos clínicos han sido entrenados con literatura biomédica, guías clínicas y bases de datos especializadas, por lo que entienden mejor los términos técnicos, los escenarios clínicos complejos y las estructuras de casos médicos. En cambio, los modelos generalistas pueden cometer errores básicos de interpretación o lenguaje.

Ejemplo de error:

"Clasifica este ECG con signos de isquemia subendocárdica."

💡En un modelo generalista, puede fallar o generar una respuesta incorrecta.

Prompt corregido:

"En base a los hallazgos típicos de isquemia subendocárdica en un electrocardiograma (descenso del ST difuso y T picudas), ¿qué causas clínicas podrían estar relacionadas según guías ESC?"

💡 Ajusta tus prompts según el modelo que estés utilizando. Si estás trabajando con un modelo generalista, simplifica la terminología y explica el contexto con mayor detalle. Si usas un modelo clínico, puedes confiar más en su capacidad para manejar tecnicismos, pero nunca renuncies a validar la salida. (6,7)

Conclusión: Del prompting genérico al prompting clínico de precisión

El prompting eficaz en medicina es una habilidad que debe desarrollarse con la misma seriedad que cualquier otra competencia clínica. Un prompt bien estructurado es como una orden médica clara: específica, contextualizada y orientada a resultados.

Desde Campus IA, promovemos una práctica clínica potenciada por IA, basada en criterios de seguridad, evidencia y responsabilidad. Comprender los errores comunes es el primer paso para evitar la desinformación, mejorar la eficiencia clínica y fortalecer la toma de decisiones.

|

Los recursos y funcionalidades mencionados en este sitio web no han sido desarrollados, financiados, promovidos ni validados por Sanofi. Sanofi los recopila y describe en Campus IA con fines puramente ilustrativos, y no se responsabiliza de la exactitud o integridad de la información resultante de su uso ni de las opiniones expresadas sobre los mismos. Es responsabilidad del profesional sanitario asegurar el uso adecuado y la supervisión de los resultados obtenidos a través de la inteligencia artificial, así como verificar la veracidad de la información y la interpretación de las opiniones de los expertos. La inteligencia artificial no debe sustituir el juicio humano del profesional sanitario, sino complementar el ejercicio de su profesión. |

Referencias

- World Health Organization (2021). Ethics and governance of artificial intelligence for health. https://www.who.int/publications/i/item/9789240029200

- Centers for Disease Control and Prevention (CDC). Typhoid Fever Treatment. https://www.cdc.gov/typhoid-fever/healthcare.html

- World Health Organization (2023). WHO guideline: use of artificial intelligence in health. Geneva: WHO.

- Greenhalgh, T. et al. (2021). Clinical reasoning in the real world: a practical guide. BMJ 372:n828.

- European Commission (2023). Artificial Intelligence in Healthcare: Trustworthy, Human-Centric & Sustainable. https://digital-strategy.ec.europa.eu

- Biswas, S. et al. (2023). Medical large language models — are we ready for clinical integration? Nature Medicine, 29(7), 1532–1538.

- Google Research. (2023). Med-PaLM: Scaling medical AI with large language models. https://research.google/blog/med-palm